在人工智能浪潮席卷全球的当下,智算中心作为支撑大模型训练、推理和各类智能应用的“数字底座”,已从单点试水走向规模化落地阶段。截至2025年,全国已建及在建智算中心超250个,算力总规模达280EFLOPS,覆盖京津冀、长三角、粤港澳等八大枢纽节点。

事实上,智算中心的规模化交付并非简单的GPU堆叠,而是一项横跨项目立项、方案设计、资源筹备、施工部署、系统上线到验收交付的复杂系统工程。其背后不仅是技术的快速迭代,还伴随运维复杂性与产业生态不成熟等难题。因此,如何“建好”智算中心只是起点,“交付即能用、并可持续运营”才是真正的考验。

本文将从技术架构、工程实施、能效管理、软件栈成熟度、产业协同和商业模式六个维度,系统剖析智算中心规模化交付的核心挑战。

01技术架构的复杂性:异构算力与高速互联的难题

智算中心的根基是算力,但与传统云数据中心相比,智算中心的技术架构复杂度更高,主要体现在两个方面:

在异构算力的管理方面,AI算力芯片正处于多元化竞争阶段,NVIDIA GPU仍然占据市场主导,国产GPU、NPU、DPU、FPGA也在不断涌现。不同厂商的芯片在编程接口、驱动优化、软件生态上差异明显,这导致算力池化和统一调度极其困难。

如何在单一智算中心内高效整合不同架构芯片?如何避免资源碎片化?如何为上层AI开发者屏蔽底层异构性?这些问题至今没有完全成熟的解决方案。

在高速互联与集群规模方面,大模型训练需要上万卡规模的并行协同,这要求极高带宽、低延迟的网络互联。目前,Infiniband和高速以太网(如RoCE)是主流选择,但当节点数扩展到数千甚至上万时,网络瓶颈、拓扑设计、流量调度都会成为“卡脖子”问题。

例如,训练GPT-4级别的大模型,需要万卡规模的GPU集群,其网络架构复杂度和工程可靠性要求远超传统互联网应用场景。技术架构的不确定性,决定了智算中心的规模化交付并非“复制粘贴”,而是每一次建设都需要重新平衡算力供给、互联设计与软件适配,导致交付周期和风险不断上升。

02工程实施的复杂性:从机房到液冷的全栈挑战

传统数据中心建设的核心难题在于供电与散热,而智算中心面临的问题则在这一基础上被进一步放大。

第一,高功率密度带来的供配电挑战。一台高端AI服务器的功耗可超过10kW,而传统通用服务器仅为2-3kW。这意味着同样的机柜面积,智算中心的电力需求提升了数倍。如何保障大规模供电的稳定性,如何规划冗余电力路径,成为规模化交付的瓶颈。

第二,液冷系统的复杂落地。风冷已经无法满足超高功耗服务器的散热需求,液冷正成为智算中心的标配。然而,液冷涉及管道铺设、冷却液循环、运维安全等一系列复杂问题:冷却液泄漏如何防范?高湿度环境下如何保障芯片安全?多厂家设备如何适配不同液冷方案?这使得智算中心的机房建设从传统的“土建+风冷”模式,演进为跨学科的工程系统。

第三,交付周期与工程协同。从设计到上线,智算中心的交付周期通常长达12-18个月。这与AI产业的快速演进存在天然错配:当一个中心交付完成时,可能芯片迭代已经更新,架构优化的需求又会倒逼改造。这种“交付-过时”的悖论,是规模化建设的一大现实困境。

03能效与绿色低碳:规模化背后的可持续难题

据测算,一个万卡规模的AI算力集群,年耗电量可达数亿度,相当于一个中等城市的居民用电。随着智算中心数量的快速增长,能耗和碳排放问题日益凸显。

首先,PUE(电能使用效率)的挑战。尽管通过液冷技术可以将PUE降低至1.1甚至1.05,但在大规模集群中保持长期稳定仍然困难。一旦制冷系统波动,可能导致能效恶化,甚至威胁集群运行。

其次,绿色能源供给的不足。“东数西算”提出要在西部建设数据中心,利用清洁能源。但现实是,清洁能源供应存在波动性,输电半径受限,导致算力需求与能源供给难以完全匹配。

再次,能效与性能的平衡问题。算力调度时常需要在“满负荷性能”与“节能模式”之间权衡。如何在保证AI训练高效性的同时,避免无谓的能源浪费,是规模化运营必须破解的难题。

04软件栈的成熟度:从AI框架到算力调度的断层

硬件可以通过采购实现堆叠,但软件生态的成熟度,决定了智算中心能否真正“好用”。

第一,AI框架的适配性不足。主流AI框架(如PyTorch、TensorFlow)对NVIDIA GPU优化成熟,但对国产芯片的支持度有限。很多国产GPU厂商需要自己适配深度学习算子库,导致开发者迁移成本高,使用体验差。

第二,算力调度与资源管理体系不完善。传统Kubernetes在大规模AI集群中并非完全适用。任务调度涉及多维度需求:显存大小、互联拓扑、作业优先级、能耗策略等,远比传统云原生调度复杂。目前成熟的AI算力调度系统仍在探索中。

第三,可观测性与运维工具不足。当集群规模扩展到万卡级别,任何微小故障都可能造成巨大损失。如何实现对GPU健康度、网络拓扑、任务运行状态的实时监控和预测,是智算中心软件栈亟需补齐的短板。

05产业协同的难题:政企关系与上下游博弈

智算中心的建设往往由政府主导、企业承建、产业链配合完成。这种模式在推动算力基础设施落地方面有优势,但也带来协同困境。

第一,政策与需求的错位问题。部分城市AI应用生态尚不成熟,算力利用率低,导致大量GPU资源闲置。算力“过剩”与“短缺”并存,成为一种结构性矛盾。

第二,上下游议价权分布不均。芯片厂商、整机厂商、数据中心运营商、AI企业之间,存在复杂的利益博弈。当芯片供给紧张时,厂商掌握绝对话语权,运营商和应用方被迫接受高成本。

06商业模式的探索:算力如何变现?

智算中心规模化交付的最终目的,是实现可持续的商业模式。但目前,算力变现仍处于探索阶段。

第一,训练市场与推理市场的不均衡。大模型训练需求集中在少数巨头,推理需求才是更广泛的市场。但推理任务对延迟、成本敏感度更高,如何在保证算力利用率的同时,实现灵活计费,是一大难点。

第二,算力即服务(CaaS)的挑战。许多智算中心提出“算力即服务”,但与云计算相比,AI算力的弹性伸缩、任务调度更为复杂,真正实现“像水电一样便捷”仍然遥远。

第三,投资回报周期过长。大规模智算中心动辄百亿级投资,而算力市场的盈利模式尚未清晰。运营商面临高额前期投入与不确定的长期回报,这也是阻碍规模化交付的重要因素。

结束语

智算中心规模化交付不是单一企业能完成的任务,而是产业链协同与政策引导的系统工程。要跨越上述挑战,需要上下游产业的协同创新,不仅要解决“造”和“建”的问题,更要聚焦“用”和“运营”的效率与效益,才能让智算中心真正成为赋能千行百业的强大引擎。

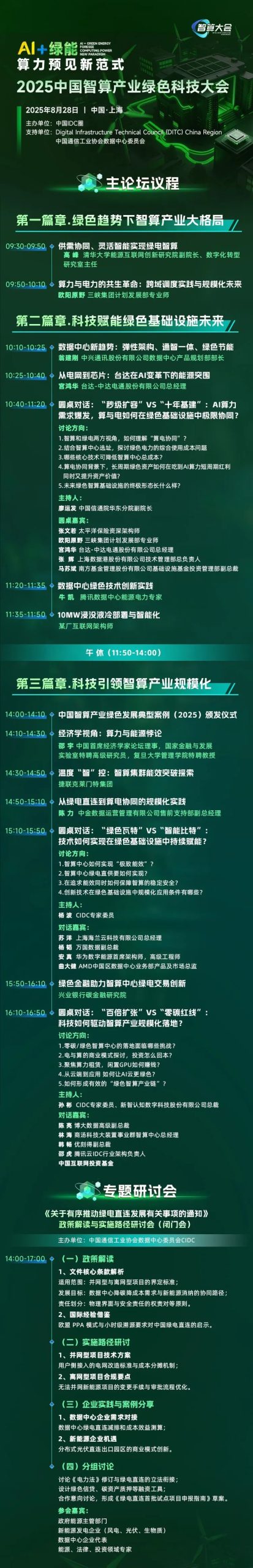

8月28日,2025中国智算产业绿色科技大会即将在上海举办,大会以“AI+绿能,算力预见新范式”为主题,汇聚政产学研用多方力量,围绕绿色智算、算电协同、绿电直连、源网荷储等绿色能源应用话题,展开深度分享与讨论。我们诚挚地邀请您共襄盛举,一同见证并参与这场即将到来的产业变革。