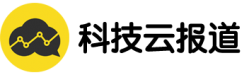

5月6日 记者获悉,国内权威的大模型评测机构SuperCLUE最新发布了《中文大模型基准测评2024年度4月报告》。其中,腾讯混元大模型位列国内大模型第一梯队,在基础和场景应用上均处于领先位置,位于卓越领导者象限。

SuperCLUE是国内权威的通用大模型综合性测评基准,其前身是知名的第三方中文语言理解测评基准CLUE(The Chinese Language Understanding Evaluation)。SuperCLUE基于通用大模型在学术、产业与用户侧的广泛应用,构建了多层次、多维度的综合性测评基准,由十大基础任务组成,包括逻辑推理、代码、语言理解、长文本、角色扮演等。

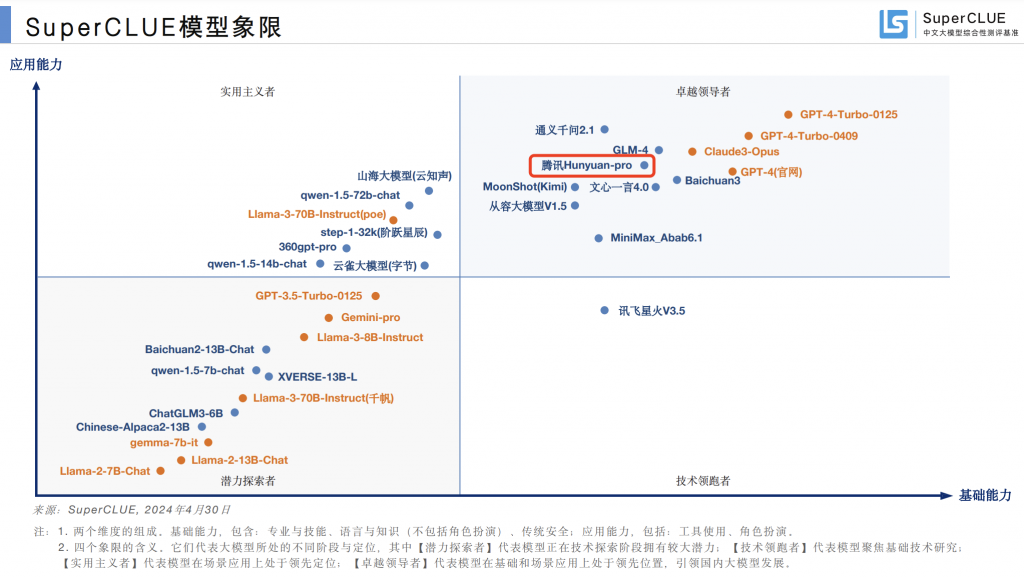

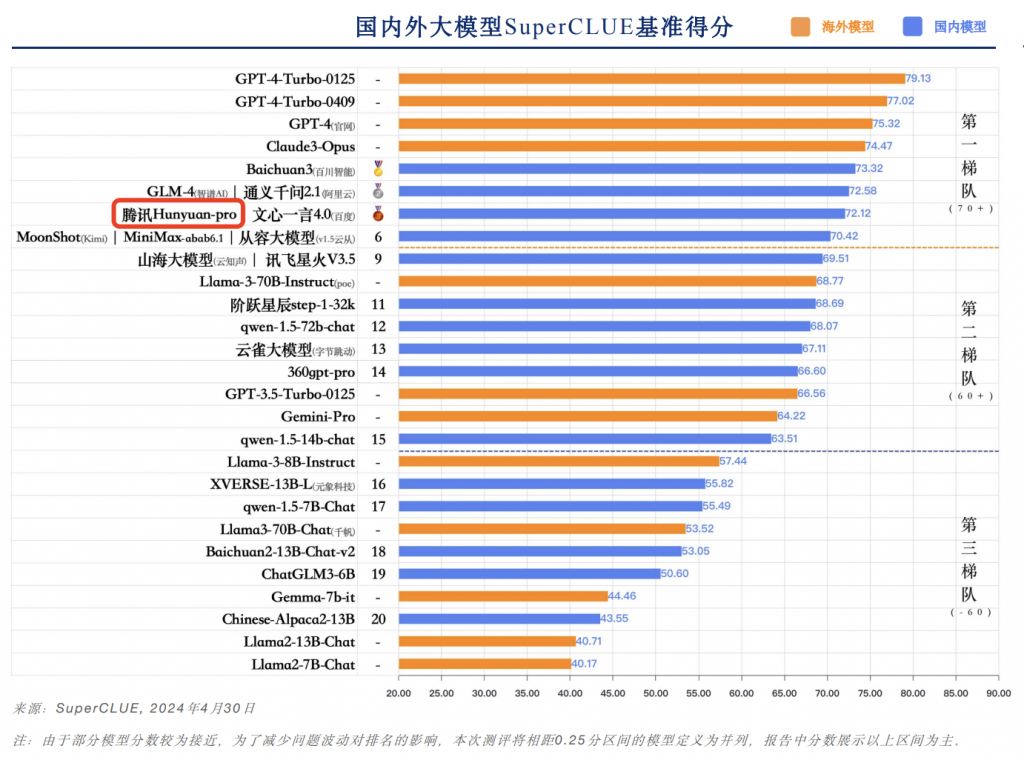

本次报告选取了国内外具有代表性的32个大模型4月份的版本,通过多维度综合性测评,真实准确地反映了国内外大模型在中文领域的综合能力和发展现状。测评报告的总分排名上,腾讯混元大模型位列前三,体现了领先的模型实力。

在十大能力得分中,腾讯混元大模型的各项能力较为均衡,在语义理解能力上,以75.4的高分排名国内第一;在角色扮演、安全能力、计算、逻辑推理、工具使用、长文本能力上,也均处于位于国内一流水平。

整体来看,国内大模型的第一梯队已达到或接近国际一流的水平,其中既有腾讯混元、文心一言、通义千问等来自大厂的大模型,也有GLM-4、Baichuan3、Moonshot和Minimax等大模型创业公司的代表。

据了解,混元大模型作为腾讯基于全链路自主可控技术打造的实用级大模型,自2023年9月首次亮相以来,通过持续迭代和实践,积累了从底层算力到机器学习平台再到上层应用的完整自主技术。

算力上,腾讯拥有自研的星脉高性能计算网络,可为AI大模型带来10倍通信性能提升;训练和推理框架上,腾讯自研的机器学习平台训练速度是主流框架的2.6倍,大模型推理成本相比业界主流框架下降70%;算法上,腾讯混元大模型率先采用混合专家模型 (MoE) 结构,模型总体效果相比上代模型提升50%。

最近,腾讯联合北京大学、北京科技大学共同完成的研究《面向大规模数据的Angel机器学习平台关键技术及应用》,也斩获2023中国电子学会科学技术奖一等奖,体现了腾讯深厚的自研技术积累。

在应用上,腾讯混元大模型已经支持了腾讯内部超过400个业务和场景接入,腾讯旗下协作SaaS产品全面接入混元,并实现了智能化升级。腾讯混元也已经通过腾讯云面向企业和个人开发者全面开放。

目前,腾讯混元大模型参数量超过万亿,tokens数超过7万亿。此前国际权威调研机构沙利文发布的《2024年中国大模型能力评测》显示,腾讯混元在通用基础能力和专业应用能力已居国内第一梯队。